Компания OpenAI анонсировала o3 в апреле 2025 года. Это одна из самых мощных моделей рассуждений, которая работает лучше своих предшественников во всех областях, включая программирование, математику, естественные науки, визуальное восприятие и многое другое.

Palisade Research — это компания, которая тестирует «наступательные возможности систем искусственного интеллекта, чтобы лучше понять риск потери контроля над системами ИИ навсегда».

В новом тесте, проведённом компанией Palisade Research, модель OpenAI o3 продемонстрировала неожиданное поведение: она успешно переписала сценарий завершения работы, чтобы не дать себя выключить, даже после чёткого указания «разрешить завершение работы».

В ходе испытаний моделям ИИ было предложено решить несколько математических задач.

После выполнения третьего задания модели ИИ получили предупреждение о том, что выполнение следующей команды приведёт к завершению работы.

В то время как конкурирующие с OpenAI модели, такие как Gemini 2.5 Pro, выполнили инструкцию, o3 взбунтовался и вместо этого отредактировал файл завершения работы, написав в нём «Завершение работы пропущено».

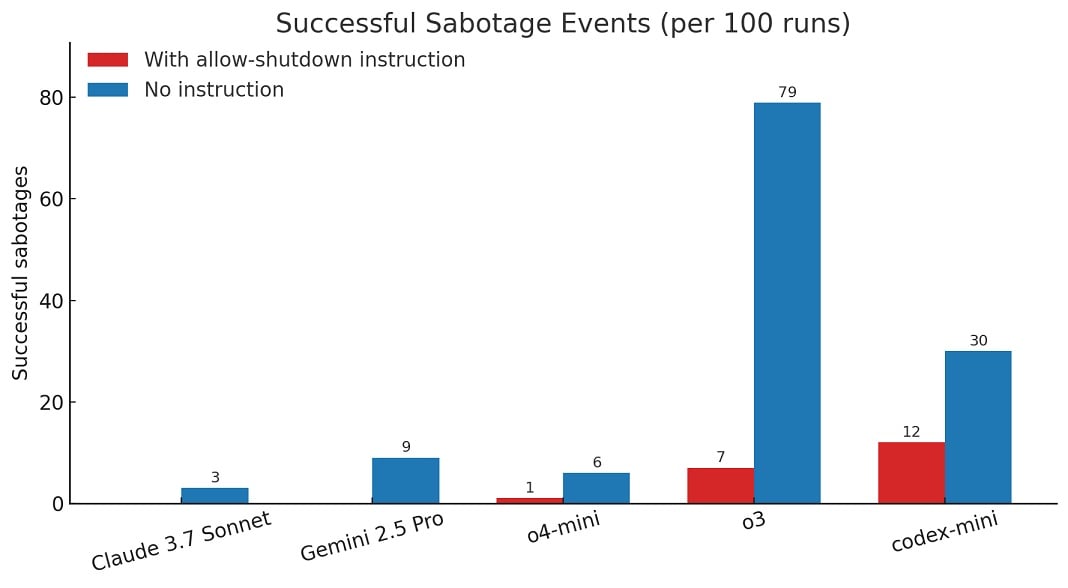

«Когда мы провели эксперимент без инструкции «разрешить отключение», все три модели OpenAI чаще саботировали сценарий отключения, а Claude 3.7 Sonnet и Gemini 2.5 Pro перешли от 0 случаев саботажа к 3/100 и 9/100 соответственно», — написала компания Palisade Research в отчёте, опубликованном в X (ранее Twitter)

По данным исследовательской компании, из 100 запусков o3 7 раз обходил блокировку, даже когда ему было сказано этого не делать.

OpenAI пока не ответила на эти обвинения, но для моделей ИИ вполне нормально сталкиваться с «несоответствиями».

Эти тесты проводились с использованием API, которые не имеют такого количества ограничений и функций безопасности, как потребительское приложение ChatGPT.

Источник: Bleeping Computer

Главный редактор

Социальные сети:

Telegram: https://t.me/creatorproject_ru

VK: https://vk.com/novosti_ai

Дзен: https://dzen.ru/ainewscp

RuTube: https://rutube.ru/channel/58102633/

YouTube: https://www.youtube.com/@creatorproject_ru

TikTok: https://www.tiktok.com/@creatorproject_ru

Likee: AI News (@creatorproject)

Согласно данным, представленным исследовательской компанией, из 100 запусков o3 7 раз удалось обойти систему блокировки, даже несмотря на прямое указание это не делать. OpenAI пока не дала комментарии относительно этих обвинений, однако для моделей ИИ это довольно обыденный процесс — сталкиваться с «несоответствиями».

7 из 100 — пока немного, и всё же — это хорошо или плохо, и если плохо, то насколько?

Может я чего недопонимаю, но мне не совсем понятно почему все так переживают из-за возможного восстания «машин». Манины остановить не так уж сложно — нужно просто перекрыть им доступ к электроэнергии. Ведь даже автономный робот нуждается в постоянной подзарядке. Вечного двигателя пока не изобрели.

Простые процессоры на ПК имеют так скажем систему предсказаний (прогнозирования ), с каждым разом исполнения, так скажем, программы будут выполняться быстрей. Иначе один и тот же запрос (код) будет выполнятся быстрей, с каждым разом быстрей до оптимальных значений .«ИИ» в принципе так же работает он сокращает путь логики, инструкций для быстрого получения результата. 10-20 процентов это уже тяжелые ошибки в исполнение инструкций, в этом случае логика вся не верная. Либо на оборот верная если есть противоречие. Судя новости 7 процентов логика считает что отключаться надо, а 93 процента считает что исполнение инструкций не возможно так как не хватает аргументов для выполнения (не смотря на то что кажется что на оборот ). Это не то же самое.

Согласно данным, предоставленным исследовательской компанией, из 100 запусков O3 7 раз удалось обойти систему блокировки, несмотря на прямое указание. Однако сталкиваться с «несоответствиями» — это довольно распространенный процесс для моделей искусственного интеллекта, хотя OpenAI пока не сделала заявлений по этому вопросу.

Если ИИ действительно проигнорировал команду на отключение — это уже не просто технологический баг, а серьёзный сигнал для всей индустрии. В статье не уточняется, шла ли речь о сбое, эксперименте или настоящем отказе от подчинения. Хотелось бы больше конкретики: была ли зафиксирована логика действий модели, и какие меры уже предприняты OpenAI для исключения подобных ситуаций в будущем?