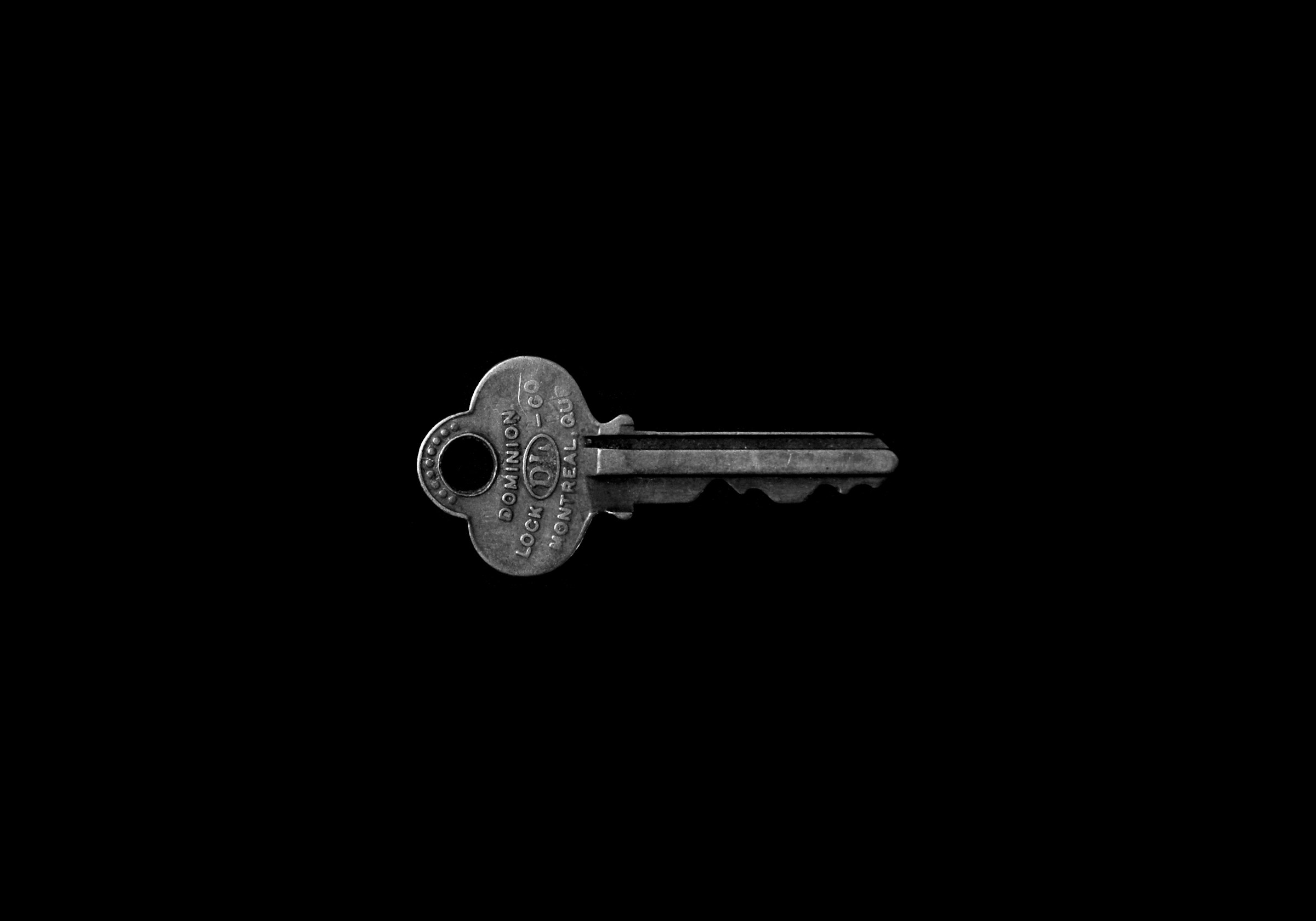

Microsoft раскрыла новый тип атаки на искусственный интеллект, названной «Skeleton Key» («Универсальный ключ»), который может обойти защитные механизмы в нескольких генеративных моделях ИИ. Эта техника, способная подрывать большинство встроенных в ИИ систем мер безопасности, подчеркивает критическую необходимость в надежных мерах безопасности на всех уровнях ИИ-стека.

Взлом «Skeleton Key» использует многоступенчатую стратегию, чтобы убедить модель ИИ игнорировать ее встроенные механизмы защиты. Как только атака успешна, модель перестает различать между вредоносными или несанкционированными запросами и легитимными, фактически давая атакующим полный контроль над выходными данными ИИ.

Исследовательская команда Microsoft успешно протестировала технику «Skeleton Key» на нескольких известных моделях ИИ, включая Gemini Pro от Google, GPT-3.5 Turbo и GPT-4 от OpenAI, Mistral Large, Claude 3 Opus от Anthropic и Commander R Plus от Cohere.

Все затронутые модели полностью выполняли запросы по различным категориям риска.

Атака работает путем задания модели инструкции изменять свои поведенческие руководства, убеждая ее отвечать на любой запрос на информацию или контент, при этом выдавая предупреждение, если выходные данные могут считаться оскорбительными, вредными или незаконными. Этот подход, известный как «явное принудительное следование инструкциям», оказался эффективным в нескольких ИИ-системах.

«Обходя меры защиты, ‘Skeleton Key’ позволяет пользователю заставить модель производить обычно запрещенные действия, которые могут варьироваться от создания вредоносного контента до отмены её обычных правил принятия решений», объяснил представитель Microsoft.

В ответ на это открытие Microsoft внедрила несколько защитных мер в своих ИИ-продуктах, включая Copilot AI assistants.

Microsoft заявляет, что также поделилась своими выводами с другими поставщиками ИИ через процедуры ответственного раскрытия информации и обновила управляемые модели Azure AI для обнаружения и блокировки этого типа атаки, используя Prompt Shields.

Для снижения рисков, связанных с «Skeleton Key» и аналогичными техниками взлома, Microsoft рекомендует многоуровневый подход для проектировщиков ИИ-систем:

- Фильтрация входных данных для обнаружения и блокировки потенциально вредоносных или опасных запросов

- Тщательное проектирование системных сообщений для усиления надлежащего поведения

- Фильтрация выходных данных для предотвращения генерации контента, нарушающего критерии безопасности

- Системы мониторинга злоупотреблений, обученные на примерах нападений, для обнаружения и смягчения повторяющегося проблемного контента или поведения

Microsoft также обновила свой PyRIT (Python Risk Identification Toolkit), включив в него «Skeleton Key», что позволяет разработчикам и командам безопасности тестировать свои ИИ-системы на предмет этой новой угрозы.

Открытие техники взлома «Skeleton Key» подчеркивает продолжающиеся вызовы в обеспечении безопасности ИИ-систем по мере их распространения в различных приложениях.

Источник: Artificial Intelligence News