В течение последнего года GPT-4o от OpenAI и Claude-3 от Anthropic доминировали на рынке. Однако, по всей видимости, последняя версия Gemini 1.5 Pro вышла на лидирующие позиции.

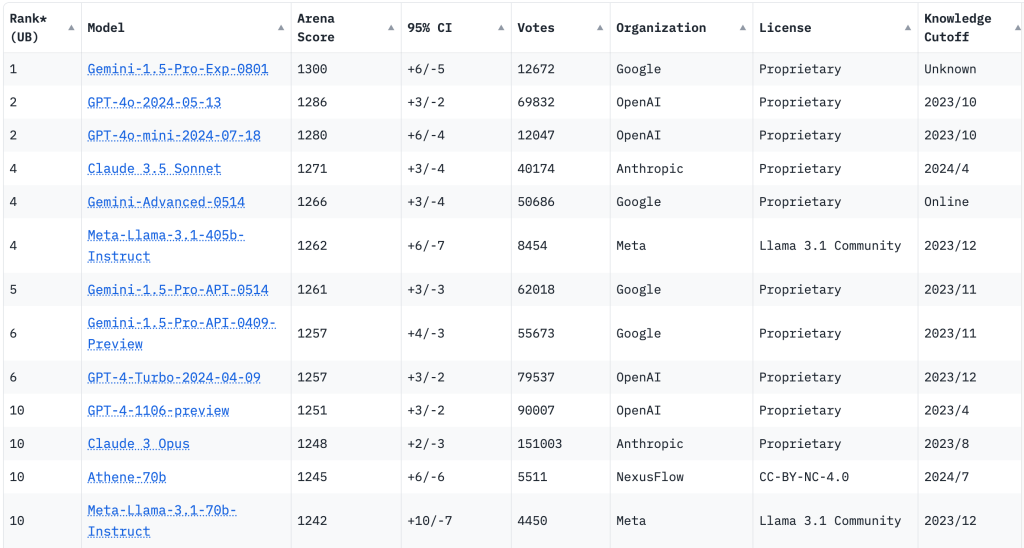

Один из наиболее признанных эталонов в сообществе ИИ — это LMSYS Chatbot Arena, который оценивает модели по различным задачам и присваивает общий показатель компетентности. В этом рейтинге GPT-4o достиг оценки в 1,286, в то время как Claude-3 получил достойные 1,271. Прошлая версия Gemini 1.5 Pro набрала 1,261.

Экспериментальная версия Gemini 1.5 Pro (обозначенная как Gemini 1.5 Pro 0801) превзошла своих ближайших конкурентов с впечатляющим результатом в 1,300 баллов. Это значительное улучшение предполагает, что последняя модель Google может обладать большими общими возможностями по сравнению с конкурентами.

Стоит отметить, что хотя контрольные показатели предоставляют ценные сведения о производительности модели ИИ, они не всегда точно отражают полный спектр её возможностей или ограничений в реальных приложениях.

Несмотря на доступность Gemini 1.5 Pro в данный момент, тот факт, что она помечена как ранний выпуск или находится на этапе тестирования, предполагает, что Google все еще может внести изменения или даже отозвать модель по соображениям безопасности или соответствия.

Это событие является важной вехой в продолжающейся гонке за превосходство в области ИИ среди технологических гигантов. Способность Google превзойти OpenAI и Anthropic по контрольным показателям демонстрирует быстрые темпы инноваций в этой области и интенсивную конкуренцию, стимулирующую эти достижения.

По мере того как ландшафт ИИ продолжает развиваться, будет интересно наблюдать, как OpenAI и Anthropic ответят на этот вызов от Google. Смогут ли они вернуть себе позиции на вершине рейтинга, или же Google установил новый стандарт производительности генеративного ИИ?

Источник: Artificial Intelligence News