Ai2 выпускает OLMo 2, семейство моделей языка с открытым исходным кодом, которое продвигает демократизацию ИИ и сокращает разрыв между открытыми и проприетарными решениями.

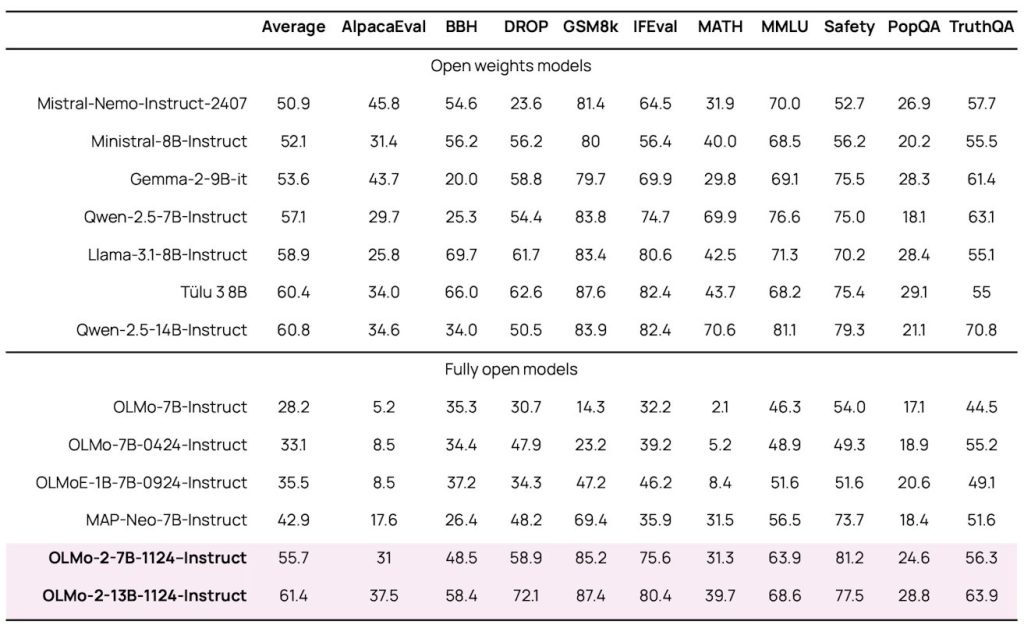

Новые модели, доступные в версиях параметров 7B и 13B, обучаются на 5 триллионах токенов и демонстрируют уровни производительности, которые соответствуют или превосходят сопоставимые полностью открытые модели, оставаясь при этом конкурентоспособными с моделями с открытым весом, такими как Llama 3.1, по английским академическим показателям.

«С момента выпуска первой OLMo в феврале 2024 года мы увидели быстрый рост экосистемы моделей открытого языка и сокращение разрыва в производительности между открытыми и фирменными моделями», — пояснил Ai2.

Команда разработчиков достигла этих улучшений с помощью нескольких инноваций, включая улучшенные меры стабильности обучения, поэтапные подходы к обучению и современные пост-тренировочные методологии, полученные из их фреймворка Tülu 3. Среди заметных технических усовершенствований — переход с непараметрической нормы слоя на RMSNorm и реализация вращательного позиционного встраивания.

Прорыв в обучении модели OLMo 2

В процессе обучения использовался сложный двухэтапный подход. На начальном этапе использовался набор данных OLMo-Mix-1124 объемом около 3,9 триллионов токенов, полученных из DCLM, Dolma, Starcoder и Proof Pile II. На втором этапе использовалась тщательно подобранная смесь высококачественных веб-данных и доменно-специфического контента через набор данных Dolmino-Mix-1124.

Особого внимания заслуживает вариант OLMo 2-Instruct-13B, который является самой эффективной моделью в серии. Модель демонстрирует превосходную производительность по сравнению с моделями Qwen 2.5 14B instruct, Tülu 3 8B и Llama 3.1 8B instruct в различных тестах.

Приверженность открытой науке

Подтверждая свою приверженность открытой науке, Ai2 выпустила полную документацию, включая веса, данные, код, рецепты, промежуточные контрольные точки и модели с настраиваемыми инструкциями. Эта прозрачность позволяет более широкому сообществу ИИ полностью проверять и воспроизводить результаты.

В выпуске также представлена оценочная структура под названием OLMES (Open Language Modeling Evaluation System), включающая 20 контрольных показателей, разработанных для оценки основных возможностей, таких как припоминание знаний, рассуждения на основе здравого смысла и математические рассуждения.

OLMo 2 поднимает планку в разработке ИИ с открытым исходным кодом, потенциально ускоряя темпы инноваций в этой области, сохраняя при этом прозрачность и доступность.

Источник: Artificial Intelligence News