Очередная AI-платформа обещает перевернуть мир видеопроизводства с ног на голову; разработчики PixVerse AI утверждают, что данная нейросеть способна создавать профессиональные ролики из простого текстового описания за несколько минут. Звучит слишком хорошо, чтобы быть правдой? Разбираемся в деталях этого инструмента, который пытается заменить целую армию видеоредакторов.

Принцип работы

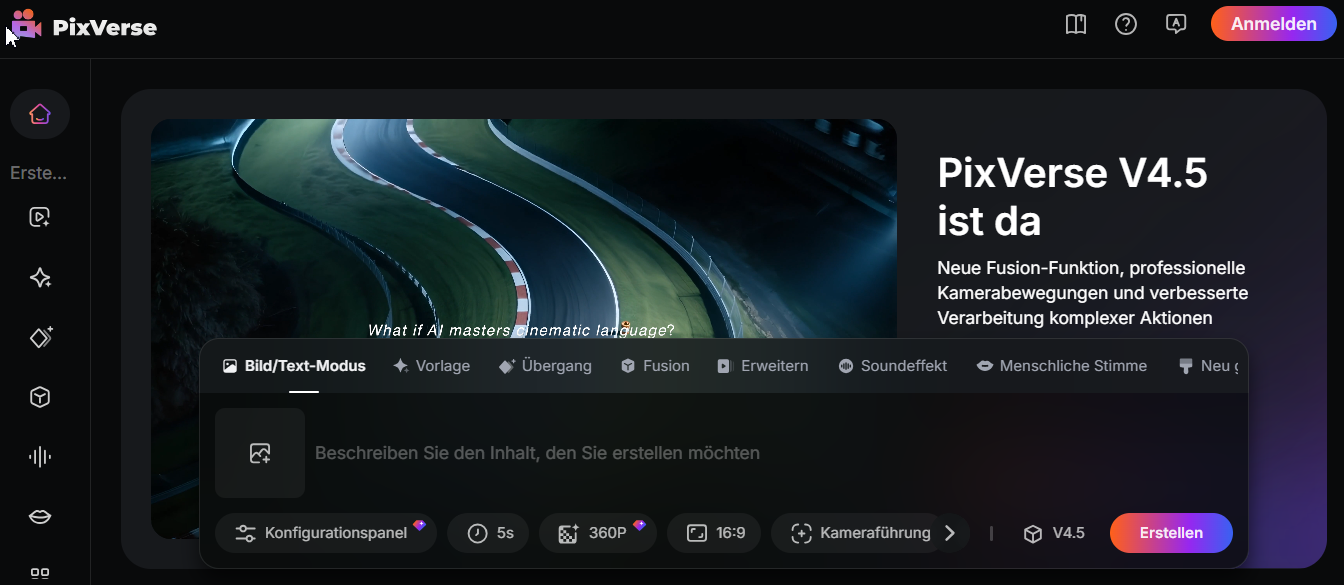

PixVerse AI представляет собой веб-платформу, построенную на технологиях машинного обучения. Основатель проекта Чарльз Инь поставил перед собой амбициозную цель — сделать видеопроизводство доступным абсолютно каждому пользователю интернета. Идея проста: загружаешь текст или изображение, выбираешь параметры, и через несколько минут получаешь готовый видеоролик. Собственно, по такому принципу сегодня и работает большинство аналогичных нейросетевых решений.

Платформа работает в облаке, что избавляет от необходимости устанавливать тяжелое программное обеспечение на компьютер. Достаточно иметь браузер и стабильное интернет-соединение. Интерфейс действительно выглядит простым — несколько кнопок, текстовое поле для ввода описания и базовые настройки. На первый взгляд кажется, что освоить платформу можно за полчаса, хотя при практическом использовании все оказывается не так просто. Большое количество дополнительных опций, имеющихся на платформе, все же требуют определенного времени на освоение.

Возможности и инструменты платформы

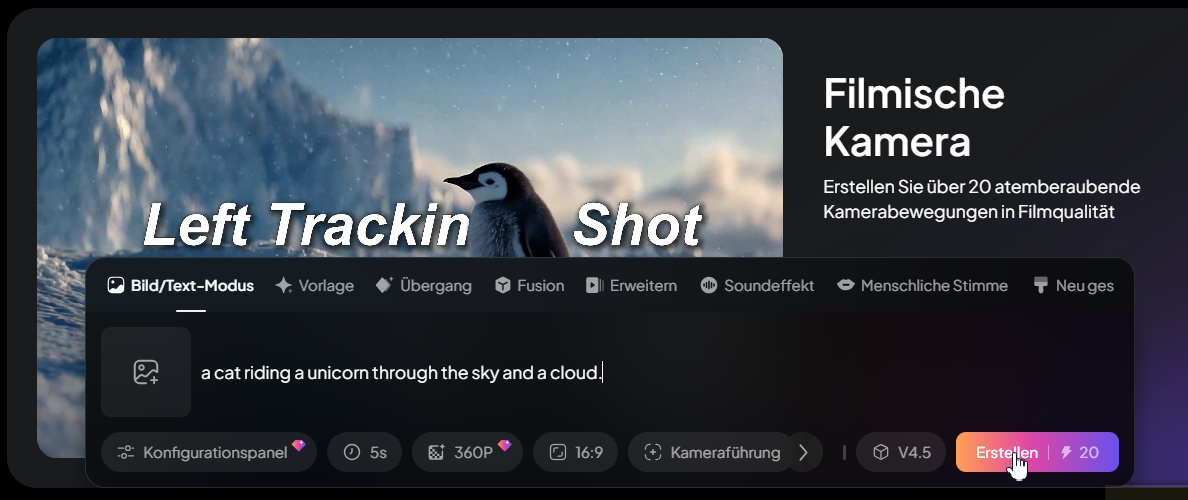

Главная фишка PixVerse AI — генерация видео из текстового описания. Пользователь вводит фразу вроде «кот едет на единороге через небо и облака», и система пытается создать соответствующую видеопоследовательность.

Алгоритм анализирует текст, выделяет ключевые объекты и действия, затем компонует их в движущиеся сцены. У нас получилось следующее видео:

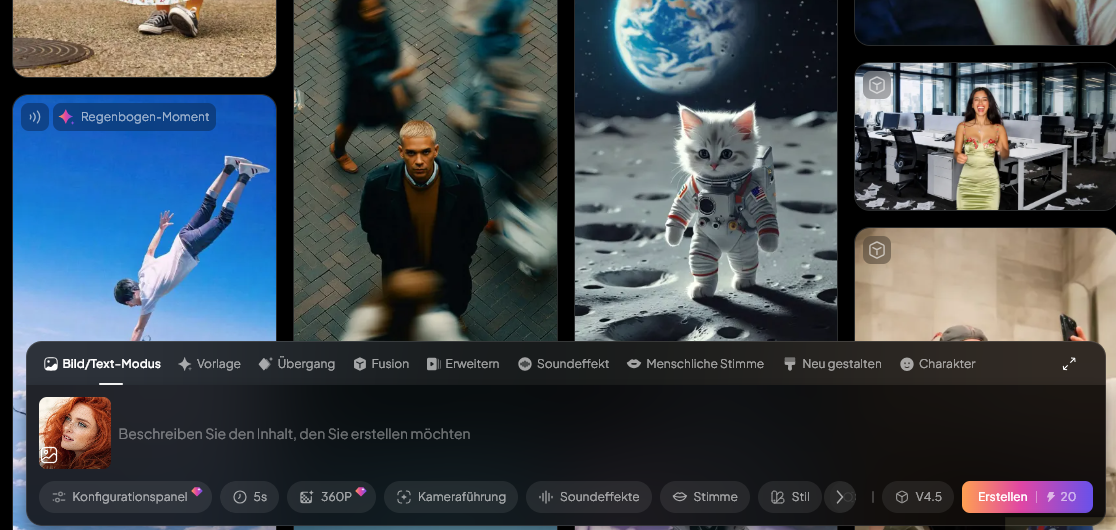

Еще одна функция, «изображение в видео», позволяет оживлять статичные картинки. Можно загрузить фотографию и получить анимированную версию с движением камеры, эффектами параллакса или простыми анимациями элементов. Особенно интересно это работает с портретами — система умеет добавлять моргание, движения головы и прочие детали.

Например, мы использовали фото:

На его основе нейросеть сгенерировала видео:

Библиотека персонажей предоставляет вниманию пользователей предустановленных 3D-моделей людей и животных. Эти персонажи можно настраивать через текстовые промпты, задавая им определенные действия, эмоции или стили одежды. Есть также коллекция анимированных животных — тут можно найти как танцующих панд, так и, к примеру, поющих пингвинов. Выглядит мило, но подойдет далеко не для всех проектов.

Система поддерживает различные соотношения сторон кадра — от квадратного формата для соцсетей до широкоэкранного, предназначенного для платформы YouTube. Можно выбирать продолжительность клипа, стиль визуализации, а также и степень детализации. Правда, тонкие настройки ограничены — глубокого контроля над процессом рендеринга платформа не предоставляет.

Практические результаты и ограничения

Стоит отметить, что качество генерируемого контента во многом будет зависеть от сложности запроса. Простые сцены с одним-двумя объектами получаются довольно неплохо — движения плавные, цвета яркие, общая картинка выглядит профессионально. Но стоит усложнить задачу, и начинаются проблемы. Как указывают пользователи, сложные композиции с множеством деталей часто выходят искаженными. Система может неправильно интерпретировать взаимодействие объектов, перепутать пропорции или создать анатомически неверных персонажей. Особенно плохо дела обстоят с текстом в кадре — надписи получаются нечеткими и часто нечитаемыми.

Время генерации варьируется от нескольких минут до получаса в зависимости от загруженности серверов. Иногда процесс может зависнуть без объяснения причин. Техническая поддержка работает медленно, а некоторые пользователи жалуются на полное отсутствие ответов на обращения.

Минусом является и то, что баллы тратятся даже на неудачные попытки генерации. Иными словами, экспериментировать с промптами становится дорого — каждая неудачная итерация съедает оплаченные кредиты. Особенно неприятно, когда система самостоятельно добавляет элементы, которые пользователь не запрашивал.

Стоимость и альтернативы

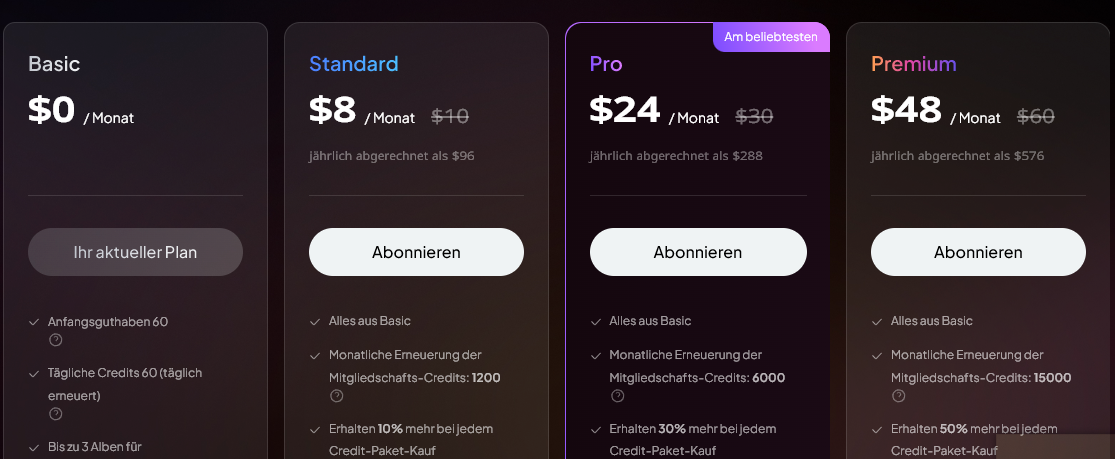

Бесплатный тариф PixVerse AI предлагает ограниченное количество генераций в день. Для серьезной работы потребуется платная подписка. Некоторые пользователи сообщают о проблемах с оплатой — неожиданных списаниях крупных сумм и сложностях с отменой подписки.

Рынок AI-инструментов для видео развивается быстро. Runway ML предлагает более продвинутые возможности редактирования, Synthesia специализируется на AI-аватарах для корпоративного контента. Luma Dream Machine фокусируется на фотореалистичной генерации. PixVerse AI находится где-то посередине — проще профессиональных инструментов, но сложнее базовых решений. Поэтому на наш взгляд, платформа может быть полезна для создания простого контента социальных сетей, прототипов анимации или образовательных материалов. Однако для коммерческих проектов высокого уровня она пока не подходит. Технология интересная, но до замены человека ей еще далеко.

PixVerse AI представляет собой любопытный эксперимент в области автоматизации видеопроизводства, но все же имеющиеся минусы не позволяют назвать ее идеальной. Возможно, через пару лет технология дозреет до серьезного инструмента. Пока же это скорее игрушка для энтузиастов, чем полноценное решение для бизнеса.

Если вы нашли ошибку, пожалуйста, выделите фрагмент текста и нажмите Ctrl+Enter. Можете написать лучше? Мы всегда рады новым авторам.

Статьи и новости о нейросетях и искусственном интеллекте, просто и понятно о сложных технологиях. Освещает современные тенденции, объясняет, как работают ИИ-системы, и показывает, каким образом нейросети меняют различные сферы жизни. Регулярно собирает подборки и топы полезных нейросетей, тщательно отбирая актуальные инструменты и сервисы, которые могут существенно упростить рабочие и повседневные задачи. В своих подборках делится описаниями возможностей каждой нейросети, а также рекомендациями по их применению, чтобы помочь читателям быстро разобраться в новых технологиях и использовать их с максимальной пользой.

Социальные сети автора:

Достойный конкурент подрос:) PixVerse AI — перспективный инструмент для быстрого создания простого контента, но пока не заменяет профессиональные решения. Его сильные стороны — скорость, доступность и креативные эффекты, а слабые — низкое качество сложных сцен и ограничения по длительности. Платформа подходит энтузиастам и блогерам, но для коммерческих проектов высокого уровня стоит рассмотреть альтернативы вроде Runway ML или Synthesia.

Очень интересный обзор! Интересно узнать, как именно работает генератор видео PixVerse AI — на чём основана логика платформы, какие модели используются, и насколько реалистичны получающиеся ролики. Какие ограничения вы заметили при тестировании: например, долго ли рендеринг, приходилось ли что‑то корректировать вручную? Мне бы хотелось понять — стоит ли пробовать, особенно в сравнении с другими инструментами видео ИИ.

Разве не удивительно, как технологии продвигаются вперед? Неужели мы уже живем в мире, где искусственный интеллект способен создавать видео? Как далеко мы зашли в развитии искусственного интеллекта? Какие возможности открывает перед нами эта технология? И какие этические вопросы она поднимает?